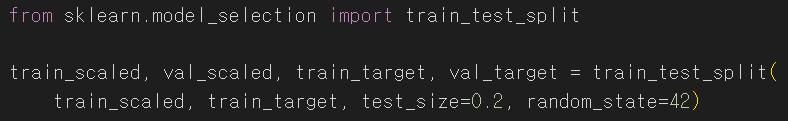

6주차Ch. 07 딥러닝을 시작합니다 ㄴ 07-1 인공 신경망 ㄴ 07-2 심층 신경망 ㄴ 07-3 신경망 모델 훈련07-1 인공 신경망✅입력층 : 픽셀값 자체✅뉴런(유닛) : z값을 계산하는 단위✅출력층 : 계산한 z값을 바탕으로 클래스 예측 인공 신경망은 기본적으로 이렇게 이루어져 잇대여.이제 모델을 만듭시다.인공 신경망에서는 교차 검증 대신 검증 세트를 사용하기 때문에훈련 데이터, 검증 데이터로 나누어 줍니다그리고 가장 기본적으로 dense 층을 만드러요.dense층은 다 연결 되어 있기 때문에 fully connected layer라고 합니다.뉴런 개수는 10개, 소프트맥스로 활성화 하도록 설정 햇어염✌️활성화 함수로 많이 사용하는건 보통 시그모이드, 소프트맥스, ReLU, ..